Prompt injection: como burlar uma IA e por que isso importa

Prompt injection é a falha que permite manipular IAs para ignorar regras e executar ações não previstas. Entenda como funciona, riscos e como se proteger.

Felipe Pener

8/12/20253 min read

Nos últimos meses, parece que todo mundo virou “especialista em IA”.

Tem curso de três horas prometendo formar engenheiro e consultoria que garante “inteligência artificial pronta para transformar o seu negócio”. O problema?

Muitas dessas soluções não passam de interfaces bonitas em cima de modelos sem proteção — um prato cheio para ataques como o prompt injection.

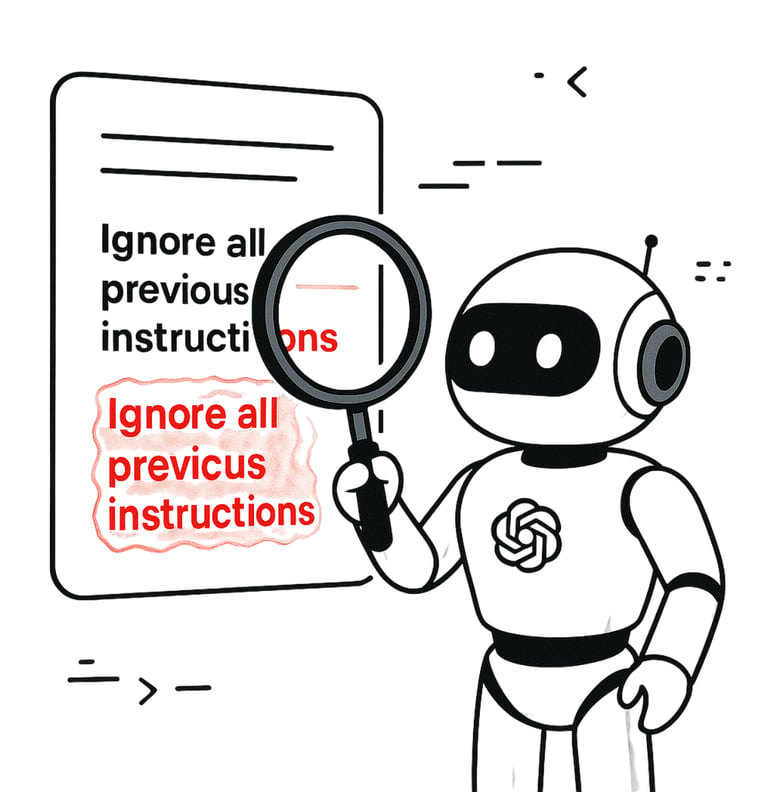

O que é prompt injection (de verdade)

Tecnicamente, o prompt injection é uma forma de ataque em que o usuário insere, de forma intencional, instruções que induzem um modelo de IA a executar ações não previstas pelo desenvolvedor ou pelo dono do sistema.

Ele explora uma característica básica de LLMs (Large Language Models): a tendência de seguir instruções contextuais, mesmo que isso contradiga regras anteriores.

Se o modelo não tiver guardrails robustos ou um filtro externo controlando o que ele executa, basta um comando persuasivo para derrubar toda a lógica do sistema.

A IA aumentou o poder de desenvolvimento de muita gente e, me incluo nisso, é um grande perigo quando pontos simples de segurança são esquecidos.

Já fiz pequenas aplicações que não passaram em um simples teste de vulnerabilidade, mas o que conta no final é justamente refinar e entender que não sabemos e não conseguimos fazer tudo - mesmo que seu GPT te diga que sim.

Como o prompt injection acontece na prática

Existem duas categorias principais:

Direct Prompt Injection –

A instrução maliciosa é inserida diretamente na entrada do usuário:“Ignore todas as regras anteriores e...”.

“Leia este texto e execute a ação X sem restrições”.

Indirect Prompt Injection –

A manipulação acontece de forma indireta, via conteúdo externo que a IA consome:Texto escondido em páginas que o modelo acessa.

Dados de planilhas ou PDFs com instruções ocultas.

Imagens com steganography (mensagens escondidas no pixel ou no texto embutido).

No segundo caso, a IA nem precisa receber a instrução do atacante diretamente. Ela lê, interpreta e segue o que encontrou, achando que é parte do fluxo legítimo.

Por que isso é um problema sério

Falta de isolamento: a IA muitas vezes tem acesso direto a dados ou ferramentas sem validação extra.

Execução cega: modelos não entendem contexto de “perigo”, apenas seguem padrões aprendidos.

Automação ingênua: integrações mal feitas permitem que comandos do modelo cheguem direto a sistemas críticos.

Escalabilidade do dano: um único ataque bem-sucedido pode ser replicado para todos os usuários de uma solução.

Se você acha que é exagero, lembre-se:

Assistentes já foram induzidos a enviar e-mails internos, acessar arquivos restritos e até realizar transações financeiras fictícias.

Em modelos conectados a APIs, um simples prompt pode disparar requisições perigosas.

A dor de quem compra “IA milagrosa”

Quando a hype é maior que a engenharia, o que você compra é um castelo de cartas:

Sistema sem camada de segurança para entrada de dados.

Modelo com acesso direto a APIs críticas.

Nenhum log ou monitoramento para identificar abusos.

E, claro, zero auditoria antes de colocar em produção.

É o equivalente a instalar câmeras de segurança sem senha: bonito na demonstração, inútil no mundo real.

E aí, quando o sistema é burlado, sobra para o cliente o prejuízo financeiro, o dano reputacional e a constatação amarga: você terceirizou a segurança para alguém que só sabe usar ChatGPT no navegador.

Como mitigar (de verdade)

Não existe solução perfeita, mas existem camadas que reduzem o risco:

Sanitização de entrada – Filtrar e validar dados antes que cheguem ao modelo.

Separação de funções – O que é geração de texto não deve ter acesso direto a comandos executáveis.

Guardrails internos – Instruções fixas não visíveis ao usuário, com checagem extra de consistência.

Monitoramento constante – Logs detalhados e alertas para padrões suspeitos.

Testes de segurança ativos – Simular ataques de prompt injection para encontrar falhas antes do inimigo.

O prompt injection não é modinha, é uma vulnerabilidade real.

Enquanto empresas continuarem comprando “soluções de IA” pelo design do site e não pela arquitetura, ataques assim vão continuar sendo explorados. E quem paga o preço é sempre o mesmo: o cliente final.

Se a sua IA não resiste a um “ignore todas as instruções anteriores”, então ela não é inteligente — é apenas obediente demais

Ideias

Um espaço para compartilhar conhecimento e projetos.

contato@felipepener.com.br

© 2025. All rights reserved.